Kommunikation ist lebenswichtig – wir kommunizieren, um zu überleben, und wir kommunizieren, um unsere Rolle in Welt und Gesellschaft zu finden und zu festigen. Menschliches Leben ohne Kommunikation ist nicht vorstellbar – selbst Einsiedler leben nicht völlig ohne Kontakt mit anderen Menschen. Leben ohne Kommunikation kann zu schweren psychischen Schäden führen.

Aber ist Kommunikation auch ohne Leben, ohne Menschen möglich? Die Entwicklung Künstlicher Intelligenz (KI) führt unwillkürlich zu dieser Frage. Wenn sich Siri und Alexa unterhalten – was passiert da? Ist das noch Kommunikation? Oder nur ein Austausch von Daten? Wenn Informationen über Netze oder andere technische Wege übertragen werden, spricht man bestenfalls von Informationsübertragung oder einer „technischen“ Art der Kommunikation. Kommunikation im Sinne eines „Teilens und Teilhabens“ ist es nicht.

Es gibt also Kommunikation im eigentlichen Sinn (bisher) nur zwischen Lebewesen, nicht jedoch zwischen Mensch und Maschine. Denn Maschinen „verstehen“ Menschen ja nicht wirklich. Für sie sind Ausdrucksformen menschlicher Kommunikation nur optische oder akustische Signale, die sie digitalisieren, speichern und analysieren können. Das Spannende daran ist die Analyse – und zwar dann, wenn sie eine technische Ebene überschreiten und nicht nur Tonkurven oder Farbverteilungen, sondern auch semantische Inhalte als solche erkennen und diese weiterverarbeiten kann. Ist das dann aber schon ein „Begreifen“ von oder gar „Anteilnehmen“ an menschlicher Kommunikation?

Künstliche Intelligenz und Kommunikation

Was aber passiert eigentlich in der „Black Box“ einer KI-Engine? Lernen solche Computer wie kleine Kinder mit Sprache umzugehen und sie in Beziehung zur Umwelt zu setzen? Nach welchen Regeln werden als Kommunikation erkannte Daten miteinander kombiniert, wie werden sie strukturiert und einander zugeordnet? Ist dabei bereits eine Art von „Intelligenz“ im Spiel? Geht es bei KI überhaupt darum, eine Art Intelligenz zu erschaffen, oder nur darum, bestimmte Anwendungsprobleme zu lösen und menschliches Denken zu unterstützen? Das wäre dann letztlich nur eine Simulation von Intelligenz, eng begrenzt auf spezielle Anwendungsfälle.

Erst wenn diese „Intelligenz“ fähig dazu ist, selbst zu lernen, sich also selbständig weiter zu entwicklen und auch einmal selbst zu reproduzieren, kann man nach allgemeinem Verständnis von KI sprechen.

Doch schon relativ simple Vorstufen von KI können den Eindruck von tatsächlicher Kommunikation erzeugen: So etwa das Computerprogramm ELIZA des MIT-Forschers Joseph Weizenbaum in den 60er Jahren, das den Dialog eines Psychotherapeuten mit einem Patienten simulieren konnte. Fünfzig Jahre später dann leistete Apples „Siri“ ähnliches, bevor im März 2016 Microsofts Experiment „Tay“ vorerst scheiterte, in dem ein eine künstliche Intelligenz einen Twitter-Account simulieren sollte. In diesem Fall jedoch wusste die Twitter-Community, dass sie es mit einem „Social Bot“ zu tun hatte und setzte es sich zum Ziel, diesen als solchen zu entlarven.

Doch was geschieht, wenn man es mit einem Social Bot zu tun bekommt und sich dessen gar nicht bewusst ist? Man also einem Twitter- oder Facebook-Account vertraut, der nicht moralisch handelt, sondern sich nur nach Algorithmen richtet?

Speziell bei Twitter, abgeschwächt aber in allen Sozialen Netzwerken ist die Gefahr groß, Accounts zu folgen oder zu vertrauen, die nicht echt sind, echt im Sinne von authentisch: Dass also derjenige Mensch dahinter steckt, der er vorgibt, zu sein. Fake-Accounts werden hauptsächlich aus zwei Gründen angelegt: Entweder jemand darf oder möchte seine wirkliche Identität nicht preisgeben, weil ihm negative Konsequenzen drohen, wenn er auf seinem Account wahre Inhalte postet. Oder jemand beabsichtigt von vornherein, falsche oder möglicherweise strafbare Inhalte zu verbreiten und will das anonym tun. Allerdings können Posts bzw. Inhalte auf solchen Accounts trotzdem authentisch sein – auch wenn sie nicht direkt einer tatsächlichen Person zugeordnet werden können.

Social Bots dagegen arbeiten anders. Sie teilen oder retweeten in erster Linie fremde Inhalte nach bestimmten Regeln; meist sind das Stichworte in Verbindung mit vorher definierten Hashtags. „Intelligent“ sind diese Bots nicht. Ebenso wenig wie „Digitale Assistenten“, die automatisiert auf Kundendienstanfragen antworten und wie eine Art Warteschleife fungieren. Auch sie reagieren bestenfalls auf bestimmte Stichworte.

Ausgeklügelter sind solche Bots, die neben der Teilen- bzw. Retweet-Funktion auch die Analysemöglichkeiten Sozialer Netzwerke nutzen. Solche Bots, die mutmaßlich im US-Wahlkampf 2016 eingesetzt wurden, können dann Inhalte in genau definierte Zielgruppen verteilen und damit eine hohe Effizienz erzielen helfen.

Zuletzt hat aber das Beispiel von Microsofts „Tay“ gezeigt, dass ein wirklicher Dialog von Social Bots noch nicht geleistet werden kann. Vielleicht können Bots in der ersten Phase einer Kommunikation bei der Filterung helfen, doch ab einer bestimmten Komplexität bzw. Differenzierung eines Dialogs müssen sich dann doch menschliche Dialogpartner in eine Kommunikation einschalten.

Mensch, Maschine – oder Mensch-Maschine?

Die Frage wird sein, wie weit diese Grenze verschoben werden kann. Im Dienstleistungssektor lassen sich (z.B. mit Hilfe komplexer Flußdiagramme) bestimmte Szenarien definieren, in denen Social Bots Kundenanfragen bis zur Lösung bearbeiten können und dann nur noch eine abschließende Bestätigung einer menschlichen Servicekraft benötigen um einen Fall zu schließen. Solche Szenarien kann man parallel zum Ersatz von Robotern in der Industrie sehen, die dort zunehmend menschliche Arbeiter ersetzen. Und solche Bots sind noch nicht einmal intelligent!

Was aber passiert, wenn es tatsächlich gelingen sollte, KI so weit zu entwickeln, dass sie abstrahieren kann, von allgemeinen auf konkrete Probleme schließen kann und schließlich anwendbare, „kluge“ Lösungen findet, auf die ein Mensch vielleicht gar nicht gekommen wäre? Oder deren Konsequenzen ein Mensch gar nicht abschätzen kann, weil KI sich so schnell weiter entwickelt, dass das menschliche Gehirn überfordert ist? An dieser Stelle setzen die sogenannten „Transhumanisten“ wie Ray Kurzweil an. Sie postulieren eine Verschmelzung des menschlichen Gehirns mit Computerchips, um genau dieser Gefahr vorzubeugen: Dass wir eines Tages die brillanten, aber vielleicht gefährlichen Lösungen nicht mehr verstehen, die uns die Maschinen präsentieren. Nur, wenn wir unsere eigenen neuronalen Netze, sprich: unsere Gehirne, digitalisieren und so kompatibel zu Computern machen, können wir im Wettlauf der Rechenleistung bestehen. Sollte es einmal so weit kommen, dass solche Mensch-Maschine-Gehirne das Denken übernehmen, wird sich die Frage nach Social Bots nicht mehr stellen, weil wir dann alle Social Bots sind.

Auch wenn das ziemlich nach Science Fiction klingt, sind die grundlegenden Technologien für eine solche Zukunft bereits weit entwickelt. Und ohne in Verschwörungstheorien eintauchen zu wollen, kann man bezweifeln, dass alles, was technisch möglich ist, auch bereits öffentlich gemacht wurde. Nicht umsonst warnen unzweifelhaft kluge Menschen wie der Physiker Stephen Hawking vor dem Überschreiten roter Linien bei der KI.

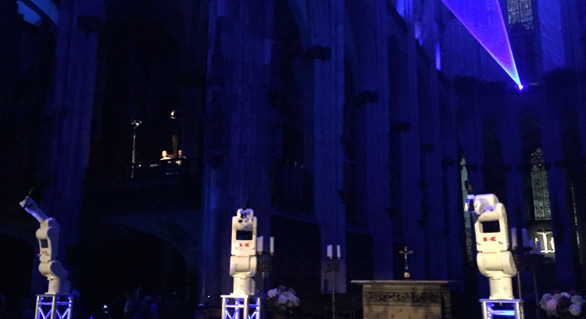

Spannend aber sind trotz aller Gefahren die ethischen Fragestellungen, die sich aus den skizzierten technischen Möglichkeiten ergeben. Zum Beispiel die Frage, ob Moral eine Funktion der Intelligenz ist. Würde eine KI auch eine „Künstliche Moral“ entwickeln, weil sich das als klug oder mathematisch sinnvoll herausstellen würde? Würde eine KI-Engine anerkennen, dass es Fragen gibt, die sie nicht lösen kann? Würde es für eine KI eine Art „höhere Instanz“ geben, der sie ein Urteil über „gut“ und „böse“ anvertrauen würde? Welche Grenzen würde eine KI überhaupt akzeptieren und wie ließe es sich vermeiden, dass sie diese Grenzen nicht selbständig neu definiert oder überschreitet? Schon der berühmte Computer „HAL 9000“ in Stanley Kubricks Film „2001: Odyssee im Weltraum“ wusste ja, sich gegen eine Abschaltung durch Menschen zu wehren, und Filme wie „Terminator“ spielen massentauglich mit dem Gedanken, dass eine Herrschaft der Maschinen die Menschheit in den Untergang führt.

Die Grenzen des Machbaren akzeptieren

Bei allen faszinierenden Möglichkeiten, die KI bietet, sollte man diese Katastrophenszenarien nicht ausblenden. Aus theologischer Sicht muss hier wieder einmal der „Turmbau zu Babel“ (Buch Genesis, Kapitel 11, Verse 1-9) erwähnt werden: Menschen, die so fasziniert von ihren Möglichkeiten, ihrem technischen Können und der dadurch zu demonstrierenden Macht sind, überschreiten immer wieder Grenzen und begeben sich in Bereiche, die ihre Fähigkeiten dann doch übersteigen. Wenn der Mensch sich Fähigkeiten zutraut, die ihn selbst zu einer Art „Übermensch“ oder Gott erheben, muss er sich der Konsequenzen sehr bewusst sein. Interessanterweise bringen dann im Fall des Turmbaus ja Kommunikationsprobleme das Projekt zum Stillstand: Die Menschen können sich nicht mehr verstehen und den Bau zu Ende bringen. Das Anerkennen von Grenzen zu akzeptieren könnte eine Herausforderung für Ethiker und Theologen sein, wenn die prinzipielle Machbarkeit alles technisch Denkbaren nicht mehr in Frage gestellt wird.

Spezifisch christlich ist die Frage, ob mit einer denkbaren Digitalisierung des menschlichen Gehirns, seiner Emotionen und seiner Rationalität auch seine Seele digitalisiert wird. Denn sie ist nach der christlichen Lehre zwar nicht materiell (und damit digitalisierbar und übertragbar?), dennoch aber an den Leib des Menschen gebunden (und damit nicht transformierbar?). Ermöglichen die transhumanistischen Visionen also vielleicht gar eine Unsterblichkeit im Diesseits? Diese Diskussion soll hier nicht geführt werden. Aber bereits diese kurzen Ausblicke zeigen, wie fundamental technische Möglichkeiten und Visionen auch die Theologie und damit die Kirchen und Religionsgemeinschaften angehen. Gerade eine Religion wie das Christentum, die für sich reklamiert, Glaube und Vernunft miteinander vereinbaren zu können, sollte sich hier deutlich positionieren. Und das bedeutet: Die Entwicklungen beobachten und verstehen lernen, sich die technische Kompetenz aneignen, um als Dialogpartner für Wissenschaft, Industrie und Gesetzgeber bereit zu stehen.

Text zum Download (CC BY-ND): Social Bots und KI